Motion Capture im Forschungsprojekt DigiLehR

Seit jeher bemühen sich Künstlerinnen und Künstler ihren Figuren – Tieren und Menschen – in Bildern Leben einzuhauchen. Leben zeigt sich in Ausdruck und Bewegung, deren Beobachtung und naturgetreue Nachbildung will gelernt sein. So beschäftigen sich seit vielen Jahren die Studierenden am Studiengang Medieninformatik (B.Sc.) der Hochschule Harz im Labor Motion Capture von Prof. Daniel Ackermann – zuständig für die Produktion interaktiver Medien und das Design multimedialer Schnittstellen – mit Motion Capture, der Aufzeichnung von Bewegungsdaten und deren Übertragung auf künstliche Figuren im 3D-Raum.

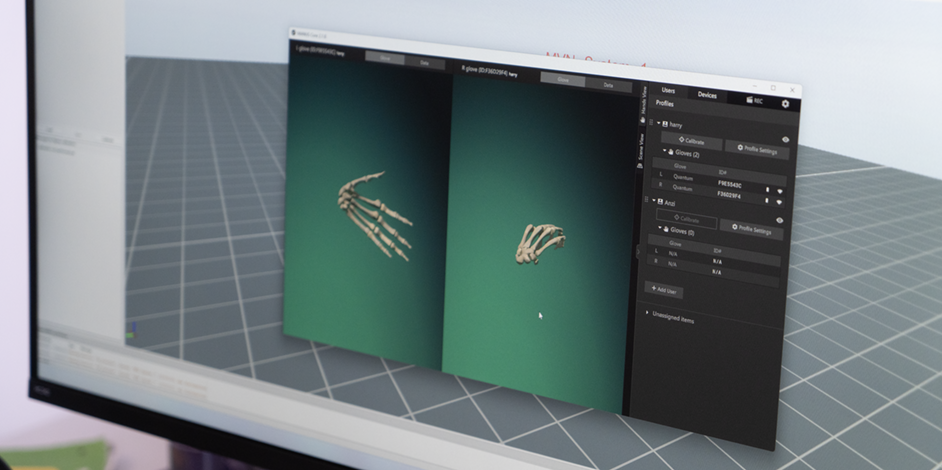

Am letzten Donnerstag nutzte das Jahresprojekt unter Leitung von Prof. Martin Kreyßig die neuen Möglichkeiten mittels Xsens Motion Capture System. Hier sind die Darsteller:innen frei in ihren Bewegungen, die Aufzeichnung kann irgendwo im Raum oder in der Natur stattfinden, denn die Bewegungsdaten werden auch im Anzug selbst aufgezeichnet. Die Projektgruppe unter Leitung von Louisa Glauche, bestehend aus Darwin Hakkenbrock, Gábor Peun, Yannick Rast, Anzor Utsmaev, Alexander Weber und Lizzy Willimczik ging einen anderen Weg und zeichneten die Bewegungen via W-LAN direkt in iClone von Reallusion auf.

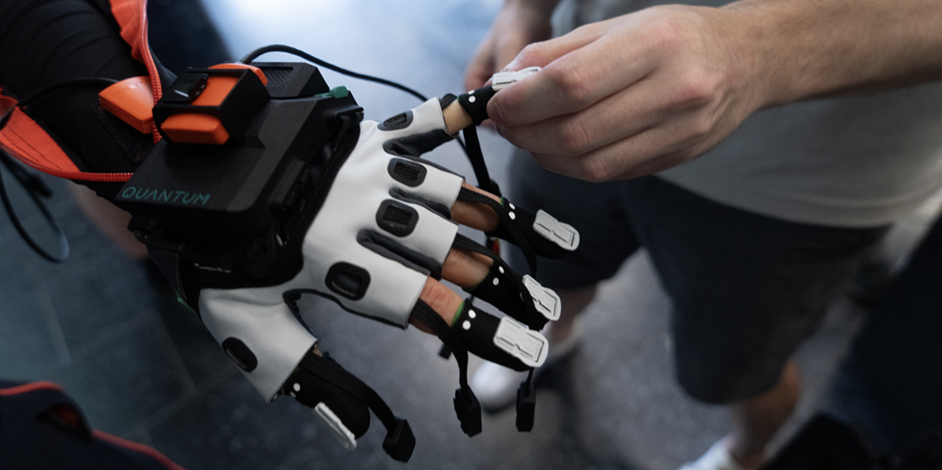

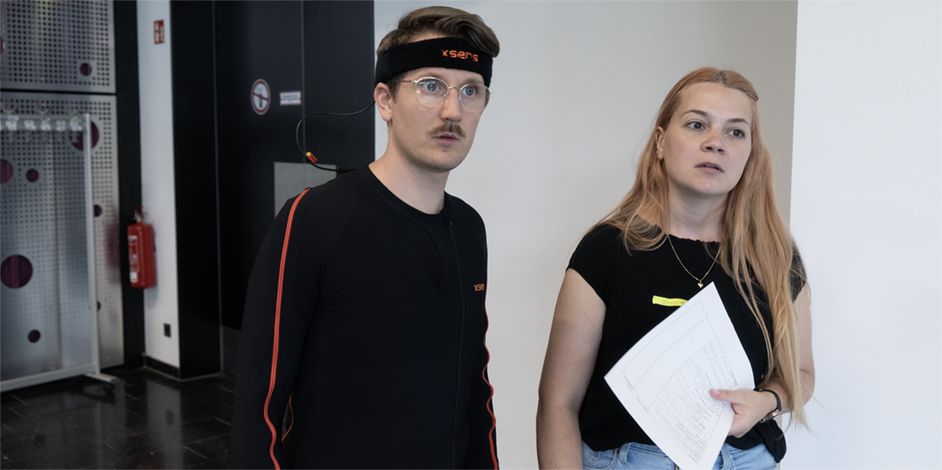

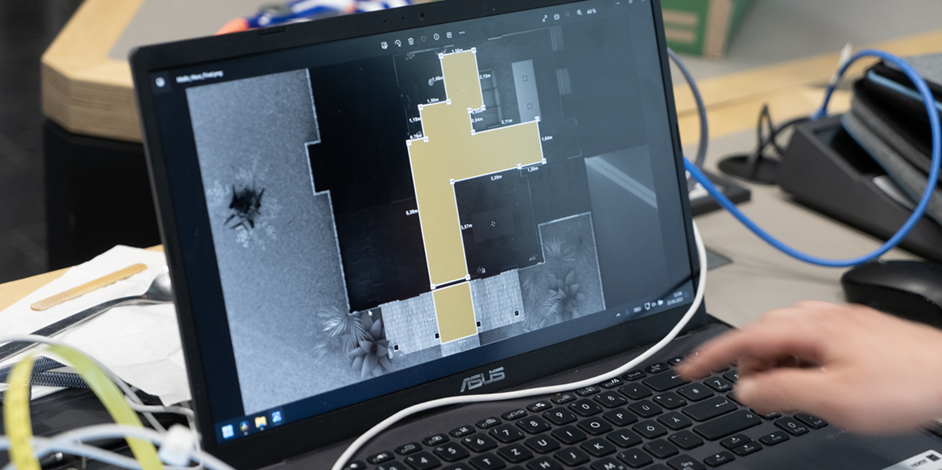

Die Bewegungen aller drei Rollen einer zukünftigen VR-Szene im Rahmen des Forschungsprojekt DigiLehR wurden von Schauspieler Jonte Volkmann gespielt. Für den Use Case Medienproduktion schlüpfte er in den Datenanzug, die Tracking-Handschuhe und in die drei ihm zugedachten Rollen: als Paketbote, Opfer und Killer. Die Aufnahmen fanden im Audimax der Hochschule Harz statt. Hier wurden die aussen und innen spielenden Filmszenen auf dem Boden markiert, das Paketauto mittels Paletten simuliert und Stative als Markierungen für Türen aufgestellt. Die Studierenden hatten Aufbau und Ablauf intensiv geprobt, so ging der eigentliche „Dreh“ unkompliziert über die Bühne. Unterstützt wurde die Gruppe zusätzlich durch Regisseurin Jessica Krecisz M.F.A., die als Dozentin die Berufsfeldorientierung Motion Capture gemeinsam mit Prof. Daniel Ackermann in diesem Sommersemester leitet.

Die Bewegungsdaten werden anschließend von den Studierenden in viele Arbeitsschritten auf die Avatare in der Echtzeitumgebung Unity übertragen. Ergänzt werden die Avatare mit Gesichter- und Mundbewegungen, die von Schauspielern gesprochen bereits aufgezeichnet worden waren. All dies zusammen ergibt am Ende eine virtuelle Filmszene, die in der VR-Echtzeitumgebung als Teil der Ausbildung von Studierenden interaktiv mit Kamera und Ton aufgezeichnet werden kann. Das Projekt wird im August 2024 beendet sein – und dann wissen wir mehr darüber, ob es möglich ist, in VR-Umgebungen das Filmhandwerk zu trainieren.

Wer mehr über das Forschungsprojekt DigiLehR erfahren möchte, hier geht es zum Blogartikel.

Schlagworte: Film, Mediengestaltung, Medieninformatik (B.Sc.), Studierende, Teamwork, Technik